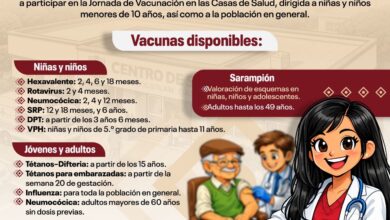

La inteligencia artificial no es feminista

Gaceta UNAM/ Alejandra del Castillo

El mismo ChatGPT lo asegura: los sesgos en los conjuntos de datos utilizados para entrenar modelos de IA es posible que perpetúen estereotipos de género o discriminación

La inteligencia artificial (IA) no tiene género, afirman sus creadores, sus impulsores, sus desarrolladores.

Bien, en estos tiempos eso suena incluyente y progresista: la IA no tiene género.

Good! Fantástico. Genial. Chingón.

Un momento. ¿Realmente no tiene género?

Entonces, ¿por qué es –sutil o abiertamente– machista cuando proporciona o genera información? ¿Por qué tiene sesgos que reproducen formas excluyentes del patriarcado y fomenta estereotipos que cosifican a las mujeres?

Pruebe y verá: feminista no es la IA. Nadie le ha dado un curso para que lo sea. Sus datos no tienen un perfil inclusivo.

¿Por qué ocurre tal cosa? La respuesta está en la forma en que la IA es programada… por hombres. Por hombres que reproducen orientaciones machistas.

Y también porque la información de la que suele echar mano la IA tiene, históricamente, un marcado componente masculino que discrimina, o al menos relega a la mujer.

La IA no puede hacer nada: esa es la información que hay, esa es la información de la cual dispone, y no tiene capacidad para modificarla, para darle un carácter feminista, para al menos dotarla de un principio de igualdad de derechos de la mujer.

Así lo explican especialistas universitarias…

Como seres humanos

A pregunta expresa, ChatGPT responde: “La IA no tiene inherentemente género ni ideología. Sin embargo, en su desarrollo e implementación pueden influir cuestiones de género de diversas maneras. Por ejemplo, los sesgos en los conjuntos de datos utilizados para entrenar modelos de IA es posible que perpetúen estereotipos de género o discriminación”.

Saiph Savage, ingeniera en computación por la UNAM y con un doctorado en Ciencias de la Computación por la Universidad de California, Santa Bárbara, recuerda que “la inteligencia artificial busca crear computadoras que puedan empezar a pensar como los seres humanos”.

La IA generativa produce nuevo contenido desde la experiencia y el aprendizaje de máquina –machine learning– con la que se educan los sistemas a partir de la información. “Esto es lo que hace ChatGPT: tú le das millones de datos con los cuales empieza a aprender ciertos conceptos”, describe la ingeniera de la UNAM.

¿Cómo influimos en la IA? Probablemente nadie o casi nadie pensó que subir una foto, dar un like o hacer un comentario en la web tendría una repercusión social hasta que la IA aprendió del lenguaje, las acciones y la interacción.

¿Qué está reflejado ahí de nosotros?

Es una pregunta que plantea la lingüista computacional María Ximena Gutiérrez, parte del programa Macrodatos, Inteligencia Artificial e Internet del Centro de Investigaciones Interdisciplinarias en Ciencias y Humanidades (CEIICH), el cual busca reflexionar desde las humanidades y la interdisciplina los avances de la IA.

Gutiérrez responde: “Lo que está reflejado ahí de nosotros tal vez tiene muchos sesgos, reproduce estereotipos, incluidas cuestiones de género que se consideran machistas. El enfoque predominante de la IA se basa en aprender de una gran cantidad de ejemplos (data-driven). El sistema aprenderá de datos de origen que pueden estar sesgados”.

¿Cómo aprendió a ser machista y patriarcal?

Si partimos de que la IA de aprendizaje metabolizó datos sesgados en cuestiones de género, la IA generativa tomará decisiones replicando aquellos que aprendió de las personas. En este camino, Saiph Savage recuerda que la IA “está entrenada para reproducir, pero también puede amplificar”, esto pensado en términos de machismo y violencia de género contra las mujeres.

Ximena Gutiérrez también explica algo importante del proceso: “Estas tecnologías son muy eficientes, pero eso conlleva un costo oculto, el cual se traduce en que a veces esos sistemas de redes neuronales artificiales tan complejos no son transparentes, no te pueden explicar por qué tomaron una decisión, y eso tiene un impacto social”.

No es neutral

Si la IA tuviera que decidir a quién contratar, probablemente elegiría a un candidato varón. Le sucedió a una empresa multinacional especializada en comercio electrónico, streaming digital e inteligencia artificial. Entre 2014 y 2015 descubrieron que sus motores de contratación discriminaban a las mujeres. ¿La razón? Su herramienta de selección, hasta ese momento experimental, trabajaba con un algoritmo que aprendió a valorar los patrones de las hojas curriculares en un tiempo de 10 años, y como el dominio masculino ha predominado en las industrias tecnológicas, una candidata sería discriminada sólo por ser mujer. Esto lo hacía no ser neutral en cuestiones de género.

Según las estadísticas de mujeres en la tecnología 2024 de WomenTech, a principios del milenio en Estados Unidos su representación laboral en la tecnología era del 9 %. Actualmente, ellas constituyen el 35 % de la fuerza laboral.

Representatividad e impacto social

La IA no sólo es una herramienta que hace uso de probabilidad y matemáticas, ahora también es un constructo social con impacto sobre la sociedad. Por ello Ximena Gutiérrez señala la importancia de conocer “la representatividad de datos digitales que hay para entrenar un sistema, un modelo de lenguaje” ¿Por qué? Porque si “tienen un sesgo muy visible machista eso se verá reflejado”.

La ingeniera de la UNAM explica la necesidad de formar grupos interdisciplinarios que incidan sobre la representatividad y soberanía de los datos. “También podemos apoyarnos en la minería de datos –proceso en el que se analizan grandes volúmenes de información para encontrar patrones que expliquen su comportamiento en un contexto determinado– a fin de descubrir tendencias que nos sugieran que los datos de origen tienen algún tipo de sesgo”.

Necesita de todos

No sólo la información de la que se ha alimentado la IA podría estar sesgada; el sesgo puede venir también de los grupos de trabajo que hacen la tecnología.

“Por ejemplo, las principales compañías que hacen IA hoy en día: Meta AI, Google, Open AI, todas estas, en realidad tienen una representación muy del norte global, casi no hay inclusión de instituciones del sur global, ahí ya hay un sesgo y eso ya va más allá de los algoritmos o la programación”, comenta Ximena Gutiérrez.

Los sesgos son múltiples y se van acumulando: la geografía hegemónica, el predominio masculino en el campo de la tecnología y la ingeniería. De la misma manera hay ausencia de participación de miembros de comunidades diversas o en estado de vulnerabilidad en el diseño de IA.

Estructuras de daño

Ejemplos sobre la IA machista son varios y no tienen que ver sólo con la contratación de las mujeres. Ellas han sido discriminadas en la industria financiera cuando se les ha negado un crédito como amas de casa o si la IA ha decidido la cantidad de dinero a la que pueden acceder conforme al registro de sus percepciones.

También se puede hablar de agresiones. “Estamos viendo casos terribles de violencia digital contra las mujeres que complejizan aún más el problema para ellas”, argumenta Aimée Vega, especialista en feminismo y comunicación del CEIICH.

Y se refiere a la generación de imágenes deep fake –un video, una fotografía o un audio generado que imita la apariencia y el sonido de una persona–, donde las mujeres son representadas como objetos sexuales y que incluso llegan a la pornografía.

La IA que no es feminista puede también contribuir a la feminización de la pobreza y la precarización de las mujeres en el mercado laboral, esto pensado en la IA que sustituye a una mujer en el trabajo, en la automatización inteligente de las industrias tradicionales o los sueldos menores que reciben las mujeres por el simple hecho de serlo.

Otro caso de violencia contra las mujeres desde la IA puede ser la vigilancia ciudadana que existe en redes sociales. Por ejemplo, en las Apps que registran información de los ciclos menstruales, donde ésta se utiliza para “identificar quiénes están en edad fértil y tomar acciones incluso legales contra aquellas que no quieren ser madres o las que abortan”, cuenta Aimée Vega.

Por su parte, Saiph Savage narra que “los algoritmos de recomendación, por ejemplo de parejas, tenían muchos sesgos sobre hacer sugerencias, y entonces las mujeres que ya eran un poco mayores de pronto el algoritmo de IA decidía limitar el tipo de opciones amorosas a las que ellas tendrían acceso. Si lo piensas, se considera un tipo de violencia, porque están cerrando las posibilidades de vida que una mujer puede tener”.

Hay que pensar lo mismo en las opciones decisión de compra y consumo que la IA puede ofrecer a las mujeres.

¿Los hombres pierden?

Aimée Vega reitera: “La tecnología no es neutral, es un dispositivo de poder y opera en un marco de relaciones donde se sostiene la desigualdad entre mujeres y hombres, la violación a los derechos humanos de ellas, así como la violencia y la discriminación en su contra”.

Añade: “La igualdad entre mujeres y hombres es el primer derecho humano, y la no discriminación es el paradigma en el que ha descansado el feminismo para hacer la construcción de los derechos humanos de ellas. El avance de las mujeres desde la perspectiva patriarcal ha sido percibido como intimidación a los varones, porque se les presenta como amenaza a los privilegios masculinos, cuando su fin último es la igualdad”.

Si no se cuenta con una estadística o cifras sobre la forma en que impacta una IA que no es feminista, Saiph Savage propone cuantificar los males. “Para entender las estructuras de daño que pueden existir y es posible que generen dolor hacia diferentes poblaciones, ayuda visualizar esto y también tener un camino sobre cómo empezar a atacar esos problemas”.

Diseños participativos

Saiph Savage comparte, desde su experiencia, que la UNAM cuenta con un curso de IA centrado en el ser humano. Esto significa tener iteración en cada parte del proceso de la creación de la IA; atacar los sesgos existentes en los datos; nutrir la IA con información en contra de la discriminación, los estereotipos y los sesgos de género; revisar las interfaces y agregar “a humanos que tomen las decisiones finales. La IA puede tener errores, es importante que permitas que haya personas que ayuden a corregirlos y percatarse de que es posible que los sesgos existan”.

De la misma forma, la UNAM trabaja en que la IA esté pensada en las mujeres y sus necesidades, y esto para Saiph Savage representa una oportunidad de innovación a través de diseños participativos.

La ola de mujeres de esta época está trabajando por una IA responsable y por todas ellas.